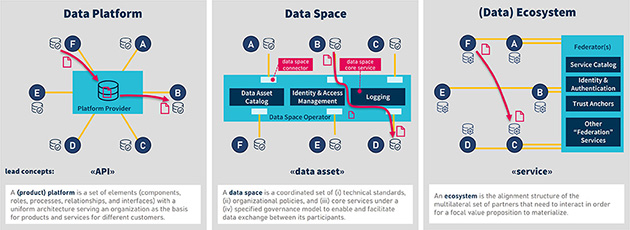

Pontus-X ist ein zentrales Ökosystem innerhalb von Gaia-X. Es war eines der ersten öffentlich verfügbaren Gaia-X-Ökosysteme mit einer Vielzahl an teilnehmenden Projekten und Unternehmen aus mehreren Ländern. Das hat es zu einem wichtigen Katalysator für die Entwicklung und den Einsatz von Gaia-X-Technologien gemacht. Mit der Anbindung von CONTACT Elements an Pontus-X ermöglichen wir einen föderierten Datenaustausch, der operative Effizienz steigert und die Datengovernance verbessert. Erfahren Sie in diesem Artikel, wie Unternehmen so in einer Welt verteilter Daten souverän agieren.

Technisch basiert Pontus-X auf einer Distributed Ledger Technology (DLT) für die dezentrale und vertrauenswürdige Verwaltung von Daten und Diensten. Ein Schlüsselelement von Pontus-X ist das Ocean Protocol von der Ocean Protocol Foundation , dass die Kontrolle über Daten in die Hände der Dateninhaber und Serviceanbieter legt.

Eines der relevantesten Features von Pontus-X zur Sicherstellung der Datensouveränität ist Compute-to-Data.

Mit Hilfe von Compute-to-Data verlassen Daten niemals die Infrastruktur des Dateninhabers und bleiben somit besser unter deren Kontrolle. Stattdessen ermöglicht es, Algorithmen zu den Daten zu bringen und wertvolle Informationen zu extrahieren, ohne die Daten selbst preiszugeben. Ein spezieller Anwendungsfall ist beispielsweise Federated Learning, also das Anlernen von KI-Modellen mit verteilten Daten. Hierbei erhalten die Nutzer*innen später lediglich das trainierte Modell, aber keinen direkten Zugang zu den sensiblen Trainingsdaten.

Durch diese Kombination verschiedener Technologien bietet Pontus-X eine solide Grundlage für einen sicheren, transparenten und souveränen Datenaustausch im Gaia-X-Ökosystem.

CONTACT Elements: Ihre Daten im Gaia-X

CONTACT Elements ermöglicht es Unternehmen, ihre Daten nahtlos in das Gaia-X-Ökosystem zu integrieren.

Ein praktisches Beispiel ist unser Partner GMN, ein führender Hersteller von Hochtechnologie-Motorspindeln. GMN nutzt Sensordaten seiner Spindeln, um datengetriebene Services anzubieten.

Wir haben CONTACT Elements so integriert, dass Qualitätsdaten einer Spindel im Shopfloor mit den Ergebnissen eines End-Of-Line-Prüfstands verknüpft werden. Diese Daten ermöglichen es GMN, seinen Kunden umfassende datengetriebene Services anzubieten, zum Beispiel die korrekte Montage zu überprüfen oder eine digitale Inbetriebnahme durchzuführen.

Dieses Datenangebot haben wir über das Pontus-X-Ökosystem realisiert. CONTACT Elements erfasst die relevanten Daten aus den Spindeln, aggregiert diese und veröffentlicht sie im Pontus-X Ökosystem. Dieser Prozess ist weitgehend automatisiert und nutzt das AAS-Integrationsmodul sowie die Datenraum-Integration der Elements-Plattform.

Durch die Integration befähigen wir Unternehmen wie GMN, ihre Daten sicher, vertrauenswürdig und souverän zu teilen, um neue Geschäftsmodelle sowie innovative Services zu entwickeln.

Föderierter Datenaustausch als Mehrwert für Ihr Unternehmen

Der föderierte Datenaustausch bietet Unternehmen erhebliche Vorteile: Im Gegensatz zu zentralisierten Plattformen bleiben die Daten an ihrem ursprünglichen Speicherort. Jede Organisation behält die Kontrolle über ihre eigenen Daten und legt fest, wer auf welche Daten zugreifen darf.

Operative Effizienz steigern:

- Schnellere Datenverfügbarkeit: Der Zugriff auf Daten in Echtzeit, ohne lange Transferzeiten oder komplexe Integrationsprojekte, beschleunigt Entscheidungsprozesse und Reaktionen auf Marktveränderungen.

- Verbesserte Zusammenarbeit: Der sichere und kontrollierte Datenaustausch unterstützt die Kooperation mit Partnern, Lieferanten und Kunden. Das führt zu effizienteren Prozessen, kürzeren Durchlaufzeiten und höherer Qualität.

- Automatisierung von Prozessen: Der automatisierte Datenaustausch zwischen verschiedenen Systemen und Organisationen reduziert manuelle Tätigkeiten und Fehler.

Verbesserte Datengovernance:

- Transparente Datenherkunft: Die Herkunft der Daten nachzuvollziehen ist besonders wichtig für Unternehmen, die in regulierten Branchen tätig sind oder strenge Compliance-Anforderungen erfüllen müssen.

- Kontrollierter Datenzugriff: Unternehmen behalten die Kontrolle darüber, wer auf ihre Daten zugreifen darf und wie diese genutzt werden. Dies ermöglicht es, sensible Daten zu schützen und Datenschutzbestimmungen einzuhalten.

- Compliance-Anforderungen einhalten: Der föderierte Datenaustausch unterstützt Unternehmen bei Compliance-Anforderungen, indem er die Einhaltung definierter Regeln und Richtlinien für den Datenaustausch sicherstellt.

Konkrete Anwendungsfälle:

- Supply Chain Management: Der Datenaustausch zwischen Lieferanten, Herstellern und Logistikdienstleistern ermöglicht eine transparente und effiziente Steuerung der Lieferkette.

- Engineering: Der Austausch von Konstruktionsdaten zwischen verschiedenen Engineering-Abteilungen oder externen Partnern beschleunigt den Entwicklungsprozess und verbessert die Qualität der Produkte.

- Produktion: Produktionsdaten zwischen verschiedenen Produktionsstandorten auszutauschen ermöglicht eine effizientere Ressourcennutzung und optimiert die Produktionsplanung.

Unser Ansatz: „Bring your own Connector“

Der Aufbau und Betrieb einer eigenen Infrastruktur kann komplex sein. Deshalb unterstützen wir Unternehmen mit unserem „Bring your own Connector“-Ansatz, der dem Gaia-X-Grundsatz der Portabilität folgt. Das vermeidet Lock-in-Effekte, indem er Unternehmen die freie Wahl lässt, welchen Konnektor sie in ihre bestehende oder neu aufzubauende Infrastruktur integrieren und wo sie ihn betreiben.

Was CONTACT Elements bietet:

- Integration in bestehende Infrastrukturen: CONTACT Elements konzentriert sich auf die nahtlose Integration in bestehende oder neu aufzubauende Infrastrukturen, die für die Teilnahme an Gaia-X erforderlich sind.

- Schnittstellen zu verschiedenen Datenräumen: Egal, ob Pontus-X oder Eclipse Dataspace Components (EDC), CONTACT Elements bietet Schnittstellen zu beiden Technologien. Dies ermöglicht es Unternehmen, flexibel zu wählen, welcher Datenraum am besten zu ihren Bedürfnissen passt.

Mit unserem „Bring your own Connector“-Ansatz nutzen Unternehmen die Vorteile des Gaia-X-Ökosystems, ohne Kompromisse bei der Flexibilität, Portabilität oder Datensouveränität eingehen zu müssen.

CONTACT Elements ebnet den Weg für den souveränen Datenaustausch im Gaia-X-Ökosystem

Die Vision von Gaia-X, ein offenes, sicheres und vertrauenswürdiges Datenökosystem zu schaffen, rückt näher. Durch die Anbindung von CONTACT Elements an Pontus-X und den „Bring your own Connector“-Ansatzes ermöglichen wir Unternehmen die Flexibilität und Portabilität, die sie benötigen.

Der föderierte Datenaustausch bietet Unternehmen eine Vielzahl von Vorteilen: von der Steigerung der operativen Effizienz und der Verbesserung der Zusammenarbeit bis hin zur Erschließung neuer Geschäftsmodelle.

Wir sind davon überzeugt, dass Gaia-X das Potenzial hat, die europäische Wirtschaft grundlegend zu verändern und Innovationen in allen Branchen anzutreiben. Mit CONTACT Elements sind Unternehmen bestens gerüstet, um von diesen Chancen zu profitieren und die Zukunft des Datenaustauschs aktiv mitzugestalten.