Während sich der Anstieg der Forschungsartikel und Konferenzen im Bereich KI laut artificial intelligence index weiter fortsetzt, lässt sich in den Medien langsam eine gewisse Ermüdung angesichts des Hypes erkennen. Zeit also, Bilanz zu ziehen: Was ist erreicht worden? Was ist praktisch möglich? Und wie geht es weiter?

Was ist erreicht worden?

In den Jahren 2018 und 2019 wurden die vorher entwickelten Methoden zur Anwendung von neuronalen Netzwerken (so definiere ich hier KI) weiter verfeinert und perfektioniert. Standen zunächst (2012-2016, Imagenet-Wettbewerb) Verfahren zur Bildklassifizierung und -verarbeitung und danach Audio-Verfahren (2015-2017, Start von Alexa und anderen Sprachassistenten) im Mittelpunkt, wurden 2019 große Fortschritte in der Textverarbeitung und -generierung gemacht (NLP = natural language processing). Insgesamt sind die zur Verfügung stehenden Techniken mit hohem Aufwand vor allem der großen Player (Google, Facebook, OpenAI, Microsoft) weiter verbessert und kombiniert worden.

Was ist praktisch möglich?

Die Anwendung von KI ist im Wesentlichen immer noch begrenzt auf vier Anwendungsbereiche:

- Bilder: Bilderkennung, -segmentierung

- Audio: Umwandlung von Sprache in Text und umgekehrt

- NLP: Textverarbeitung und -generierung

- Labeled Data: Vorhersage des Labels (z.B. Preis) aus einer Menge von Featuren

Diese Liste ist überraschend kurz, gemessen an der Aufmerksamkeit, die KI in den Medien erhält. Die beeindruckendsten Erfolge von KI ergeben sich allerdings aus einer Kombination der Techniken wie z.B. Sprachassistenten durch Kombination von Audio, NLP und Labeled Data zur Umwandlung der Eingabe in Text, Erkennung der Textintention mit NLP und Vorhersage des Sprecherwunsches durch Anwendung von riesigen Mengen von Labeled Data, also vorherigen Auswertungen ähnlicher Äußerungen.

Entscheidend für die Entwicklung gerade dieser KI-Anwendungsfelder waren:

- Das Vorliegen großer Mengen frei verfügbarer Benchmark-Datensätze (Datensätze für Machine Learning), an denen Algorithmen entwickelt und verglichen wurden

- Eine große Forschergemeinde, die sich gemeinsam auf die Benchmark-Datensätze verständigt hat, und ihre Algorithmen in öffentlichen Wettbewerben vergleicht (GLUE, Benchmarks AI, Machine Translation u.a.)

- Eine freie Verfügbarkeit der entwickelten Modelle, die als Ausgangspunkt für den praktischen Einsatz dienen (beispielhaft Tensorflow Hub)

An Hand dieser Voraussetzungen kann man schnell einschätzen, wie realistisch manche Marketing-Fantasien sind. Z.B. gibt es für das oft plakativ vorgebrachte Einsatzgebiet Predictive Maintenance weder Benchmarkdatensätze noch eine Forschergemeinde und entsprechend auch keine Modelle.

Wie geht es weiter?

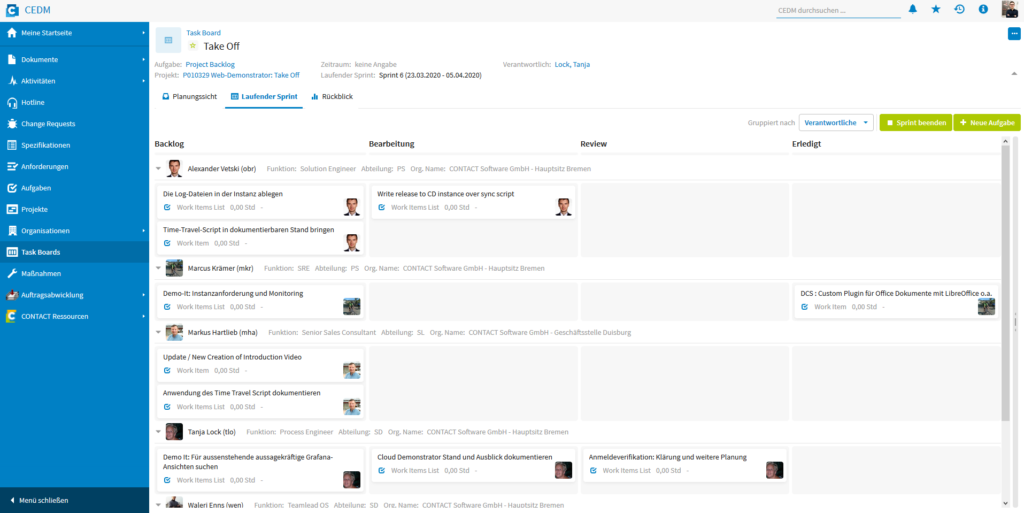

Es ist zum einen abzusehen, dass die weitere Entwicklung im KI-Bereich sicherlich zunächst in den vorgenannten Anwendungsfeldern weitergeht und sich an den Randbereichen weiterentwickelt. Zum anderen zeichnen sich Bereiche ab, die ähnlich wie die vorgenannten Einsatzgebiete unter Aufwendung großer öffentlicher und privater Mittel (z.B. werden OpenAI und Deepmind mit Milliardensummen von Elon Musk bzw. Google bezuschusst) vorangetrieben werden. Exemplarisch für große Investitionen in diesem Bereich steht sicher das autonome Fahren aber auch der Bereich IoT. Insgesamt sehe ich folgende Bereiche, die sich 2020-2022 stark weiterentwickeln:

- Die Verbindung von Reinforcement Learning mit KI-Gebieten zum schnelleren Anlernen von Modellen

- Eine weitere Verstärkung im Bereich autonomes Fahren, die sich aus der Anwendung und Kombination von KI und Reinforcement Learning ergibt

- Durchbrüche in der Verallgemeinerung der Erkenntnisse aus der Bildverarbeitung auf 3D (Geometric Deep Learning und Graph Networks)

- Eine Verschmelzung von traditionellen Methoden aus der Statistik mit neuronalen Netzwerken

- IoT-Zeitreihen (s.u.)

Einen großen Wandel sehe ich durch das Aufkommen von IoT und der damit einhergehenden Sensorik und Daten auf uns zukommen. IoT-Daten sind ihrer Natur nach Zeitreihen, die zur Auswertung gefiltert, kombiniert, geglättet und angereichert werden müssen. Zu diesem Zweck ist bisher relativ wenig Spezifisches passiert. Es könnte sein, das ab 2020 – 2022 dieses Thema einige überraschende Wendungen und Durchbrüche für uns bereithält. Insbesondere die deutsche Industrie, die von den ersten Entwicklungen im Bereich KI eher wenig profitiert hat, dürfte hier ein vielversprechendes Einsatzgebiet finden.